翻译视频和音频

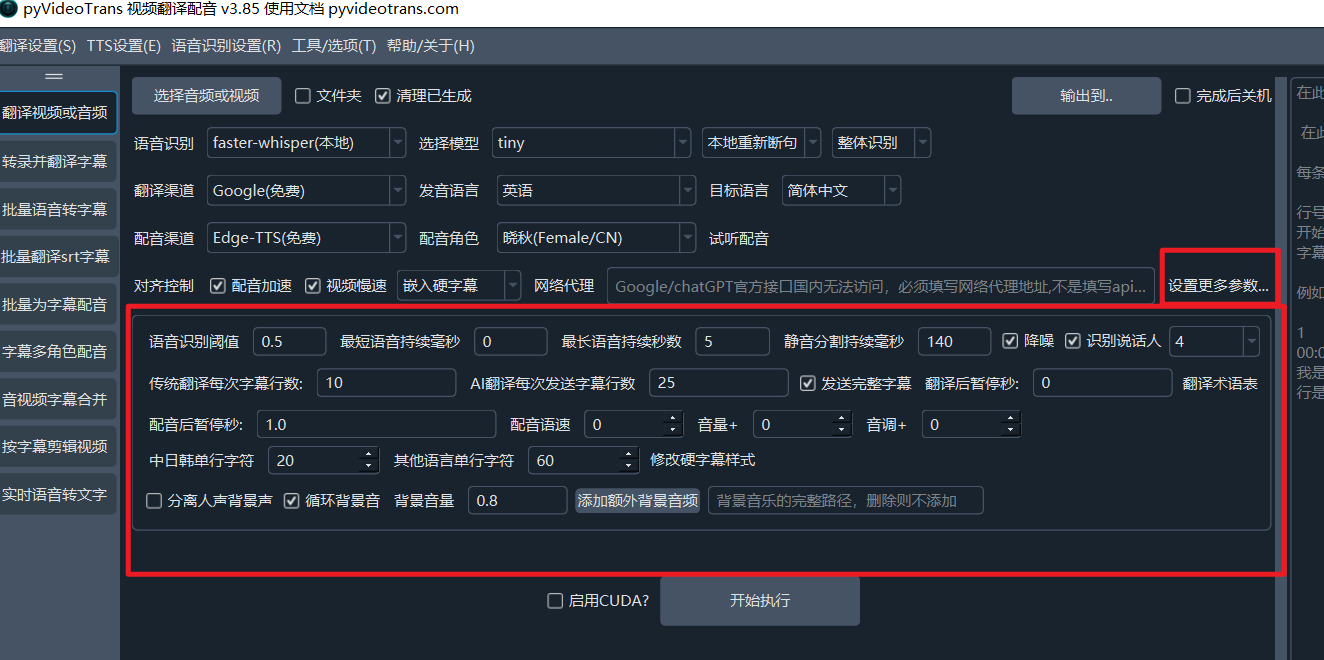

这是软件的核心功能,也是软件启动后的默认功能界面

以下将一步步带您完成一个完整的视频音频翻译任务。

第 1 行:选择要翻译的视频

支持的视频格式

mp4/mov/avi/mkv/webm/mpeg/ogg/mts/ts支持的音频格式

wav/mp3/m4a/flac/aac

选择音频或视频:点击该按钮,选择一个或多个需要翻译视频音频文件(按住Ctrl可多选)。文件夹:勾选此项可批量处理整个文件夹内的所有视频。清理已生成:若需对同一视频重新处理(而不是使用缓存),请勾选此项。输出到..:默认翻译后的文件保存到原视频目录下的_video_out文件夹,点击此按钮可单独设置翻译后视频的输出目录。完成后关机:处理完所有任务后自动关闭计算机,适合大批量、长时间任务。

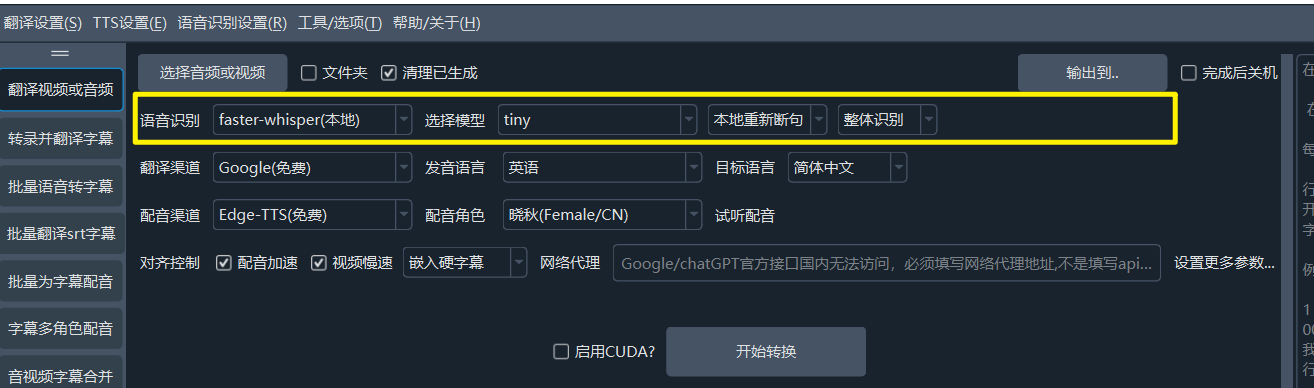

第 2 行:语音识别渠道

语音识别:用来将音频或视频中的说话声转录为字幕文件,这一步的质量直接决定后续效果。支持十多种不同识别方式,faster-whisper(本地):这是本地模型(第一次运行需在线下载模型),速度和质量都较好,如无特殊需要,可选它。它有十来个不同大小的模型可选,最小最快最节省系统资源的模型是tiny,但准确度很低,不建议使用,效果最好的是 large-v2/large-v3, 建议选择他们。.en结尾和distil-开头的模型只支持英语发音的视频使用。openai-whisper(本地):和上方模型基本类似,不过速度更慢一些,准确度可能略微高一点,同样建议选择 large-v2/large-v3 模型。阿里FunASR(本地):阿里的本地识别模型,对中文支持效果较好,如果你的原始视频是中文说话,可尝试使用它,同样第一次需在线下载模型此外还支持 字节火山字幕生成、OpenAI语音识别、Gemini语音识别、阿里Qwen3-ASR语音识别等多种在线API及本地模型

默认断句|本地重新断句|LLM重新断句: 可选择默认断句或使用大语言模型对识别出的文字进行智能断句和标点优化,或基于标点符号和时长对识别出的文字进行本地算法重新。

整体识别和批量推理:

整体识别将使用内置VAD对语音活动进行检测和区分,断句效果较佳,批量推理按照设定的最大语音持续时长将语音切分,然后每次16份同时识别,速度更快,但断句略微差点。

第3行 翻译渠道

翻译渠道:翻译渠道用来将转录后的原始语言字幕文件,翻译为目标语言字幕文件,内置十几种翻译渠道供选择

- 免费传统翻译: Google翻译(需代理)、微软翻译(无需代理)、DeepLX(需自行部署)

- 收费传统翻译:百度翻译、腾讯翻译、阿里机器翻译、DeepL

- AI智能翻译:OpenAI ChatGPT、Gemini、DeepSeek、claude、智谱AI、硅基流动、302.AI 等,需自备SK密钥并填写在

菜单-翻译设置-对应渠道设置面板内。 - 兼容AI/本地模型:同时支持自行本地部署大模型,只需要选择 兼容AI/本地模型 渠道,并将api地址填写到菜单-翻译设置-本地大模型设置内即可

- 发音语言:是指原始视频中人物说话的语言,必须正确选择,如果不确定,可以选择

auto。 - 目标语言:就是你希望将音视频翻译成的目标语言。

- 翻译术语表:用于AI翻译时,发送给AI的术语

第4行 配音渠道

配音渠道:翻译后的字幕文件,将使用这里指定的渠道进行配音,支持在线配音API例如OpenAI TTS/阿里Qwen-TTS/Edge-TTS/Elevenlabs/字节火山语音合成/Azure-TTS/Minimaxi等,也支持本地部署的开源TTS模型,例如 IndexTTS2/F5-TTS/CosyVoice/ChatterBox/VoxCPM等。其中Edge-TTS是免费配音渠道,开箱可用。需要配置的一些渠道,在菜单--TTS设置--对应渠道面板中填写相关信息。

- 配音角色:每个配音渠道一般都有多个发音人供选择,先选中目标语言后,即可选择配音角色。

- 试听配音:在选中某个配音角色后,即可点击试听当前角色的声音效果。

第 5 行:同步对齐和字幕

由于不同语言语速不同,翻译后的配音时长可能与原视频不符,这里可以进行调整。 主要针对配音后的时长大于原时长时进行调整,以避免声音重叠、视频已停止但声音未结束的情况,对于配音后时长变短的情况不做处理。

配音加速:如果某个配音片段比原声音片段长时,加速配音以匹配原时长。视频慢速:同样当某个配音比视频长时,放慢该片段的视频播放速度以匹配配音时长。(若选中,处理会比较耗时,同时生成大量中间片段,出于尽量减小质量损失考虑,整体尺寸会比原视频增大数倍)不嵌入字幕:只替换声音,不添加任何字幕。嵌入硬字幕:将字幕永久“烧录”到画面中,无法关闭,在任何地方播放均会显示字幕。嵌入软字幕:将字幕作为独立轨道封装进视频,播放器可选择开关,网页中播放时无法显示字幕。(双):每条字幕都由两行组成,分别是原始语言字幕和目标语音字幕。- 网络代理:对于中国大陆地区,使用 Google、Gemini、OpenAI等国外服务,需要使用代理,如果你有vpn等服务,并且知道代理端口号,可在此填写,形式类似

http://127.0.0.1:7860等。

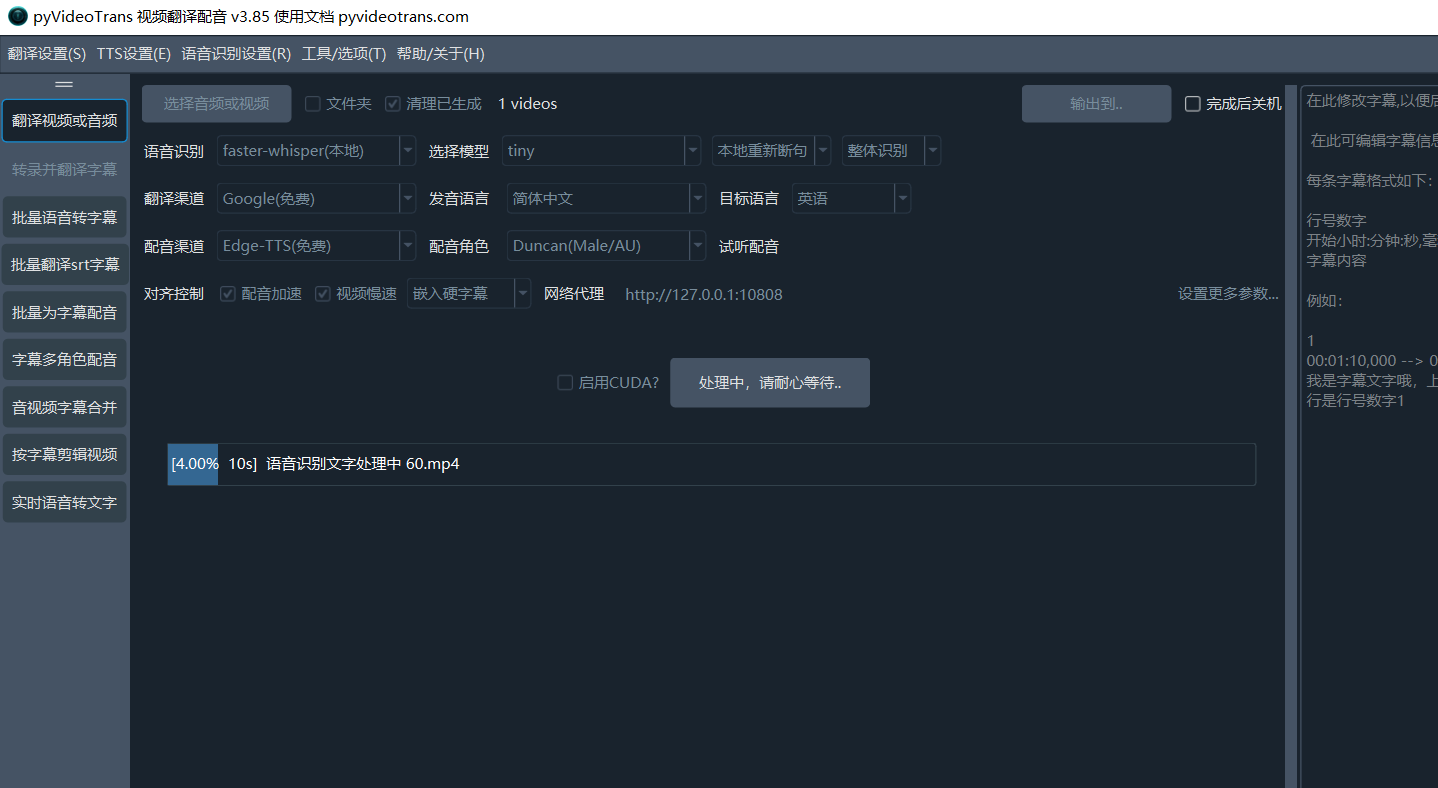

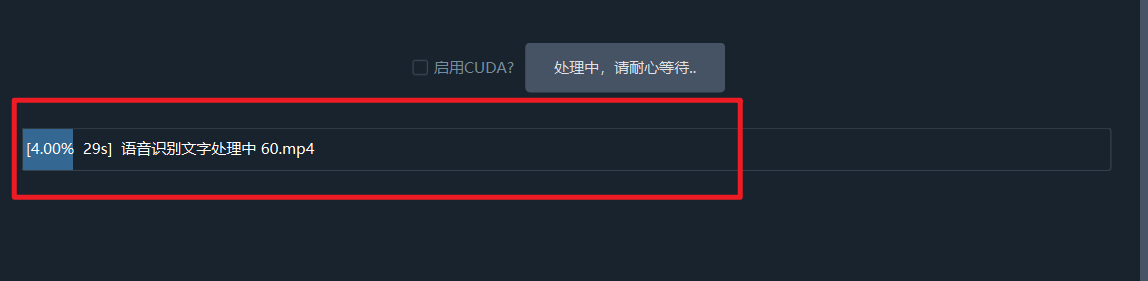

第 6 行:开始执行

- CUDA加速:在Windows和Linux上,如果您有 NVIDIA 显卡并正确安装了 CUDA 环境,请务必勾选此项,它能将语音识别的速度提升数倍甚至数十倍。

一切设置完毕后,点击【开始执行】按钮。

如果一次选择翻译多个音视频,将同时交叉执行,中间不会暂停。

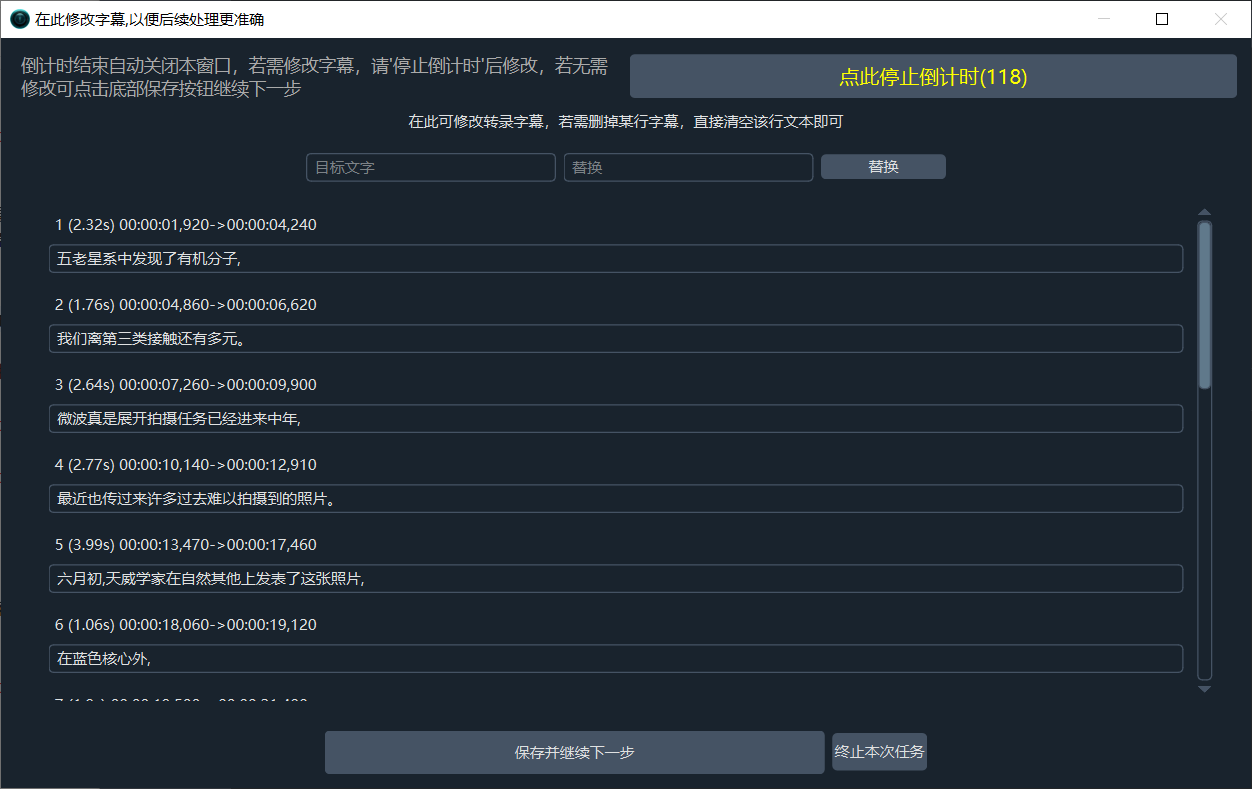

一次仅选择一个视频时,在语音转录完成后,将弹出单独的字幕编辑窗口,你可在此对字幕进行修改,以便后续过程更准确。

语音识别阶段完成后,弹出字幕修改窗口

在字幕翻译完成后弹出的窗口中,可为每个说话人设置不同的发音角色,还可以为每行字幕单独指定一个发音角色

字幕翻译阶段完成后,弹出字幕修改和发音角色修改窗口

第 7 行:设置更多参数

如果你还想进行更精细的控制,例如语速、音量、每行字幕字符数、降噪、说话人识别等,可以点击 设置更多参数...,点击后如图

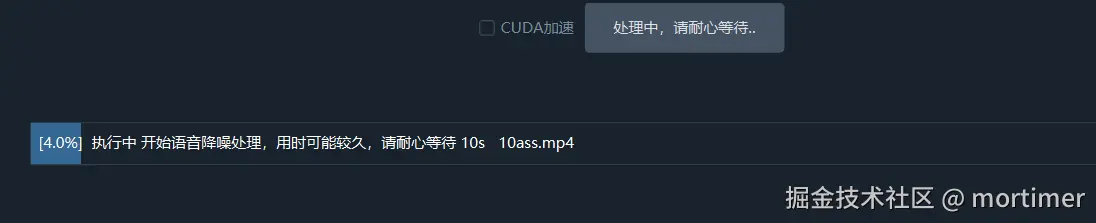

降噪:若选中,将在语音识别之前,先一步对语音中的噪声进行消除,识别准确度将得到提升

识别说话人:若选中,将在语音识别结束后,尝试识别区分说话人(准确度有限),后边的数字代表预先设定想识别出几个说话人,若提前确定,将增加准确度,默认不限制,

配音语速:默认0,若填写

50则代表语速加快 50%,-50代表降速 50%音量+:同样默认0,填写

50代表音量增大 50%,-50代表降低50%音调+:默认0,

20代表音调调高 20Hz变得尖锐,反正-20降低20Hz变得低沉语音阈值: 表示音频片段被认为是语音的最低概率。VAD 会为每个音频片段计算语音概率,超过此阈值的部分被视为语音,反之视为静音或噪音。 默认0.45,越小越灵敏但可能误将噪声视为语音

最短语音持续毫秒数: 如果检测到的语音片段长度小于此值,会被丢弃,目的是去除短暂的非语音噪音。填写数字,单位是ms,默认0ms 过大会出现漏字

最长语音持续秒数: 限制单个语音片段的最大长度。超过此时长时强制分割。填写数字,单位是秒,默认5秒

静音分割持续毫秒数: 在语音结束时,需等待的静音时间达到此值后,才会分割出语音片段。填写数字,单位ms,默认140ms,也就是只在大于此值的静音片段处分割

传统翻译渠道每批字幕行数: 传统翻译渠道每次发送字幕行数

AI翻译渠道每批字幕行数: AI翻译渠道每次发送字幕行数

发送完整字幕: 是否在使用AI翻译渠道时发送完整字幕格式内容

翻译后暂停秒: 每次翻译后暂停秒数,用于限制请求频率

配音后暂停秒: 每次配音后暂停秒数,用于限制请求频率

中日韩单行字符:嵌入硬字幕时,中日韩语言每行字幕最大字符数量

其他语言单行字符:嵌入硬字幕时,非中日韩语言每行字幕最大字符数量

修改硬字幕样式:点击将弹出专门的硬字幕样式编辑器

分离人声背景声:选中将把视频中的背景伴奏声和说话声分离出来,在最终完成配音合并时,再将伴奏背景声嵌入进去(此步操作非常缓慢,极耗资源)

循环背景音:如果背景音频时长小于最终的视频时长,选中将循环播放背景音,否则以静音填充

背景音量:重新嵌入后新的背景音量设置,默认0.8,即音量降低为原来的 0.8 倍

额外添加背景音频:你也可以选择本地某个音频,作为新的背景伴奏

第 8 行:进度条

任务完成后,点击底部进度条区域即可打开输出文件夹。您会看到最终的 MP4 文件以及过程中生成的 SRT 字幕、配音文件等素材。