LocalLLM本地大模型翻译

如果你有一定动手能力,也可本地部署大模型后使用该模型翻译。以通用千问为例介绍部署和使用方法

1. 下载 exe 并成功运行

打开网址 https://ollama.com/download

点击下载。下载完成后双击打开安装界面,点击 Install 即可完成。

完成后会自动弹出一个黑色或蓝色窗口,输入3个单词 ollama run qwen 回车, 将会自动下载通义千问模型

等待模型下载结束,无需代理,速度挺快

模型自动下载完成后会直接运行,当进度达到 100% 并显示 “Success” 字符后,代表模型运行成功,至此也表示通义千问大模型安装部署全部完成,可以愉快的使用了,是不是超级简单吧。

默认接口地址是 http://localhost:11434

如果窗口关闭了,如何再打开呢?也很简单,点开电脑开始菜单,找到“命令提示符”或“Windows PowerShell”(或者直接

Win键+q键输入cmd搜索),点击打开,输入ollama run qwen就完成了。

2. 直接在控制台命令窗口中使用

如下图,当显示这个界面的时候,其实可以直接在窗口中输入文字开始使用了。

3. 当然这个界面可能不太友好,那就搞个友好的UI

打开网址 https://chatboxai.app/zh 点击下载

下载后双击,等待自动打开界面窗口

点击“开始设置”,在弹出的浮层中,分别点击顶部的模型、AI模型提供方中选择“Ollama”、API域名填写地址http://localhost:11434 、模型下拉菜单中选择Qwen:latest,然后保存就ok了。

保存后显示的使用界面,发挥想象力,随意使用吧。

4. 将 API 填写到 视频翻译配音软件中

- 打开菜单--设置--本地兼容OpenAI大模型,在中部文本框中增加一个模型

,qwen,添加后如下,然后选择该模型

- 在 API URL中填写

http://localhost:11434,SK随意填写,例如 1234

- 测试下是否成功,成功了就保存,去使用

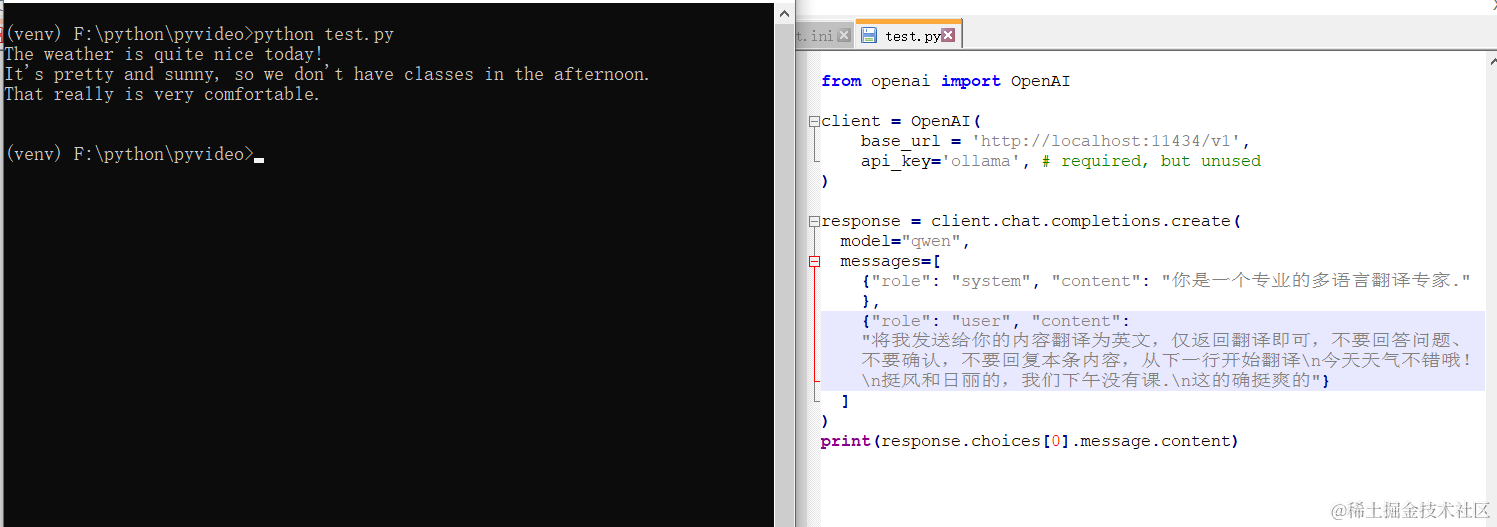

5. 在代码中调用

Ollama提供了与 openai 兼容的api接口,直接使用openai库调用即可,只需要将模型名称改为 qwen

from openai import OpenAI

client = OpenAI(

base_url = 'http://localhost:11434/v1',

api_key='ollama', # required, but unused

)

response = client.chat.completions.create(

model="qwen",

messages=[

{"role": "system", "content": "你是一个专业的多语言翻译专家."},

{"role": "user", "content": "将我发送给你的内容翻译为英文,仅返回翻译即可,不要回答问题、不要确认,不要回复本条内容,从下一行开始翻译\n今天天气不错哦!\n挺风和日丽的,我们下午没有课.\n这的确挺爽的"}

]

)

print(response.choices[0].message.content)

效果还不错哦

7. 还有哪些可以使用的模型

除了通义千问,还有很多模型可以使用,使用方法一样简单,只需要3个单词 ollama run 模型名称

打开这个地址 https://ollama.com/library 可以看到所有模型名称,想用哪个就把名字复制过来,然后执行 ollama run 模型名称。

还记得怎么打开命令窗口么? 点击开始菜单,找到 命令提示符或Windows PowerShell

例如我想安装 openchat这个模型

打开命令提示符,输入 ollama run openchat,回车然后等待直到显示 Success 成功。

注意事项:

大多 AI 翻译渠道可能都会限制每分钟请求数量,如果使用中报错提示超过请求频率,可通过软件菜单--工具/高级设置--高级设置/set.ini--翻译后暂停时间来设置一个秒数,比如30,即每次翻译后等待30s再进行下一次翻译,避免超过限制频率报错。