开源免费项目,精力所限文档更新可能滞后,请以实际软件界面为准

这是一款功能强大的开源视频翻译/语音转录/语音合成软件,致力于将视频从一种语言,无缝转换到包含另一种语言配音和字幕的视频。

核心功能一览

- 全自动视频翻译、音频翻译:智能识别转录音视频中的说话声,生成源语言字幕文件,再翻译为目标语言字幕文件,接着进行配音,最后将新的音频与字幕合成到原视频中,一气呵成。

- 语音转录/音视频转字幕:批量将视频或音频文件中的人类说话声,精准转录为带时间轴的 SRT 字幕文件。

- 语音合成/文字转语音 (TTS):利用多种先进的 TTS 渠道,为您的文本或 SRT 字幕文件生成高质量、自然流畅的配音。

- SRT 字幕文件翻译:支持批量翻译 SRT 字幕文件,保留原有时间码和格式,并提供多种双语字幕样式。

- 文稿对齐与打轴:根据音视频及已有的文字稿,将文字稿转为时间轴精准的srt字幕

- 实时语音转文字:支持实时监听麦克风,并将说话声转为文字

软件工作原理

在开始之前,请务必理解本软件的核心工作方式:

先将音频或视频中的人类说话声通过【语音识别渠道】生成字幕文件,然后经【翻译渠道】将该字幕文件翻译为指定的目标语言字幕,接着继续将该字幕使用所选的【配音渠道】生成配音音频,最后将字幕、音频、原视频三者嵌入并对齐,完成视频翻译流程。

- 可以处理:任何包含人类语音的音视频,无论它有没有内嵌字幕。

- 无法处理:只有背景音乐和硬字幕,但没有任何人说话的视频。本软件也无法直接提取视频画面中的硬字幕。

如果你需要提取视频里的硬字幕,可以尝试使用另外一个工具,基于智谱AI的视觉大模型 GLM-4.6V-FLASH , 点击查看

下载与安装

1.1 Windows 用户 (预打包版)

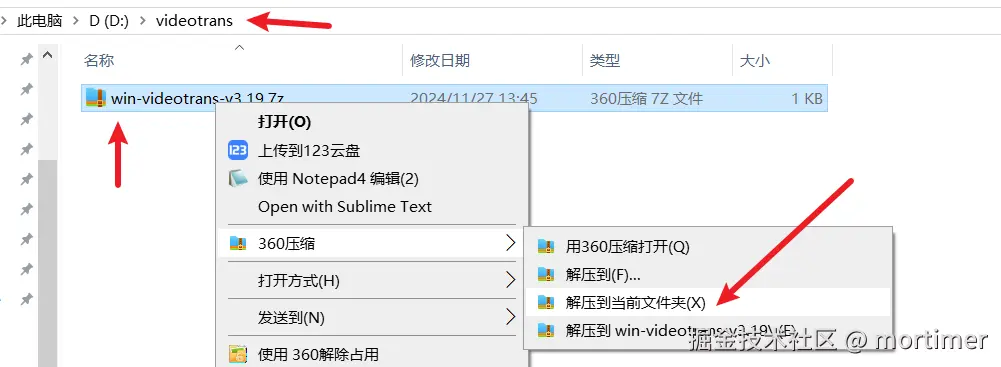

我们为 Windows 10/11 用户提供了开箱即用的预打包版本,无需繁琐配置,下载解压即用。

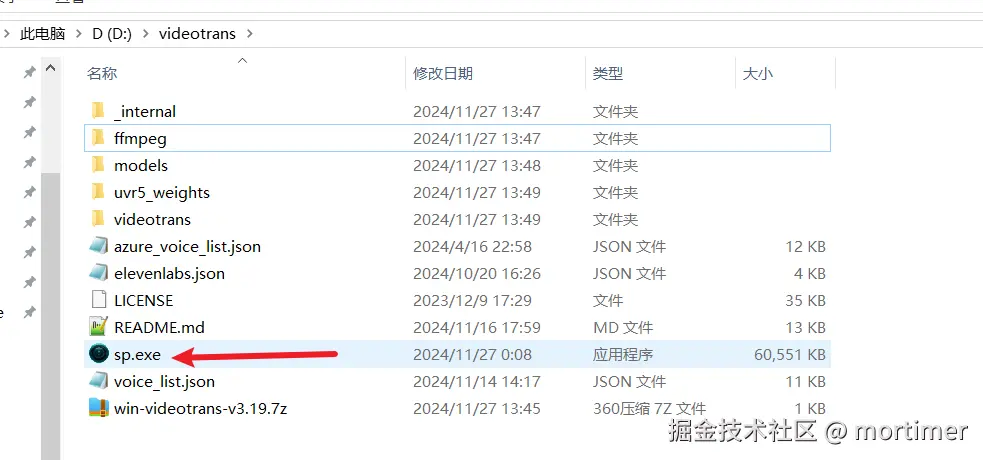

解压注意事项

请不要直接在压缩包中双击 sp.exe 使用,这样必然会报错 错误地解压是导致软件无法启动的最常见原因,请严格遵守以下规则:

- 禁止使用管理员权限路径:不要解压到

C:/Program Files、C:/Windows等需要特殊权限的系统文件夹。 - 推荐将软件解压到仅包含英文和数字的文件夹中:解压路径强烈不建议包含任何中文、空格或特殊符号,存放路径也不可太深。

- 强烈推荐:在 D 盘或 E 盘等非系统盘,新建一个纯英文或数字的文件夹(例如

D:/videotrans),然后将压缩包解压到此文件夹内。

启动软件

解压完成后,进入文件夹,找到 sp.exe 文件,双击运行即可。

软件首次启动时需要加载较多模块,可能需要几十秒时间,请耐心等待。

1.2 MacOS / Linux 用户 (源码部署)

对于 MacOS 和 Linux 用户,需要通过源码方式进行部署。

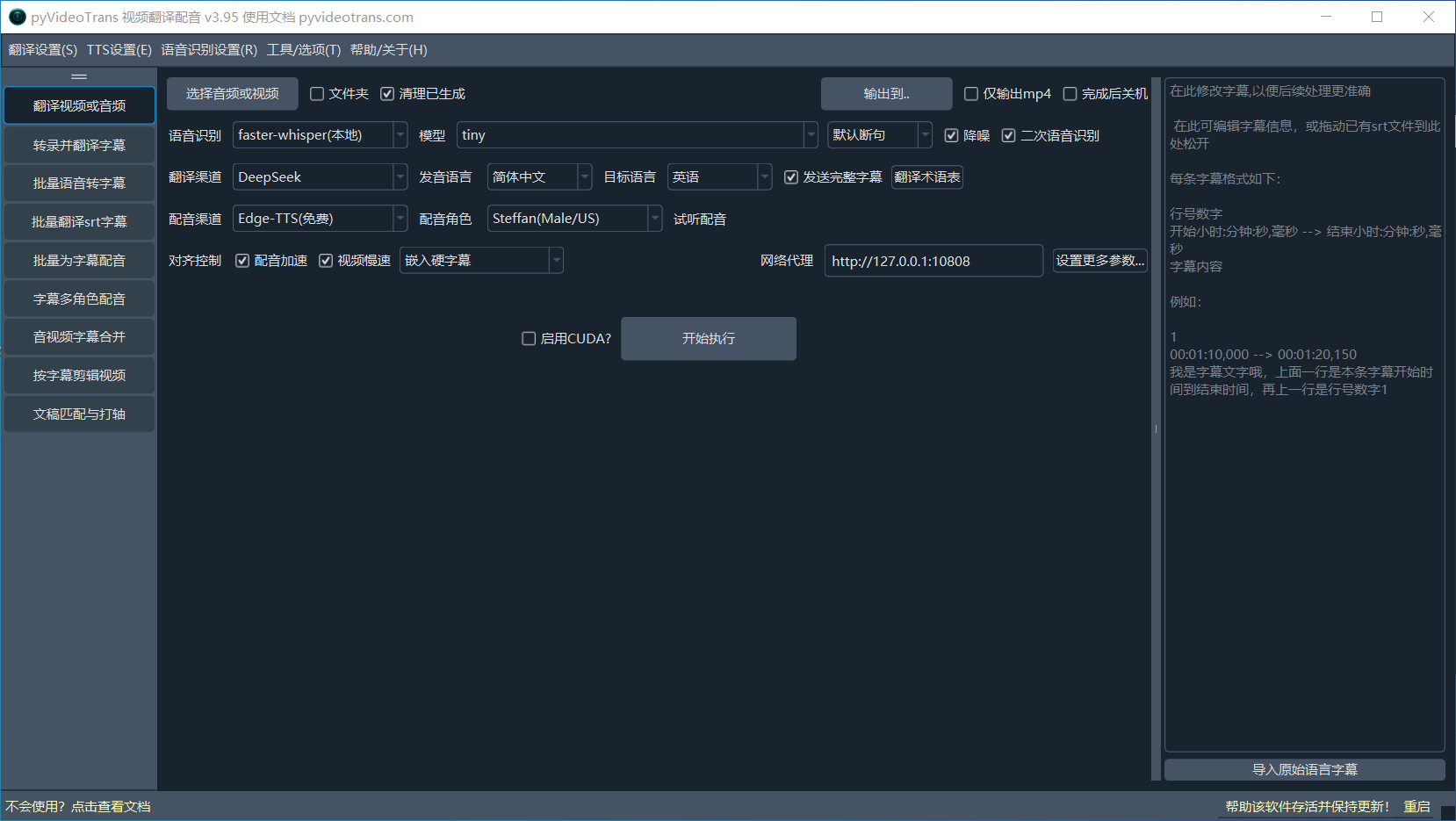

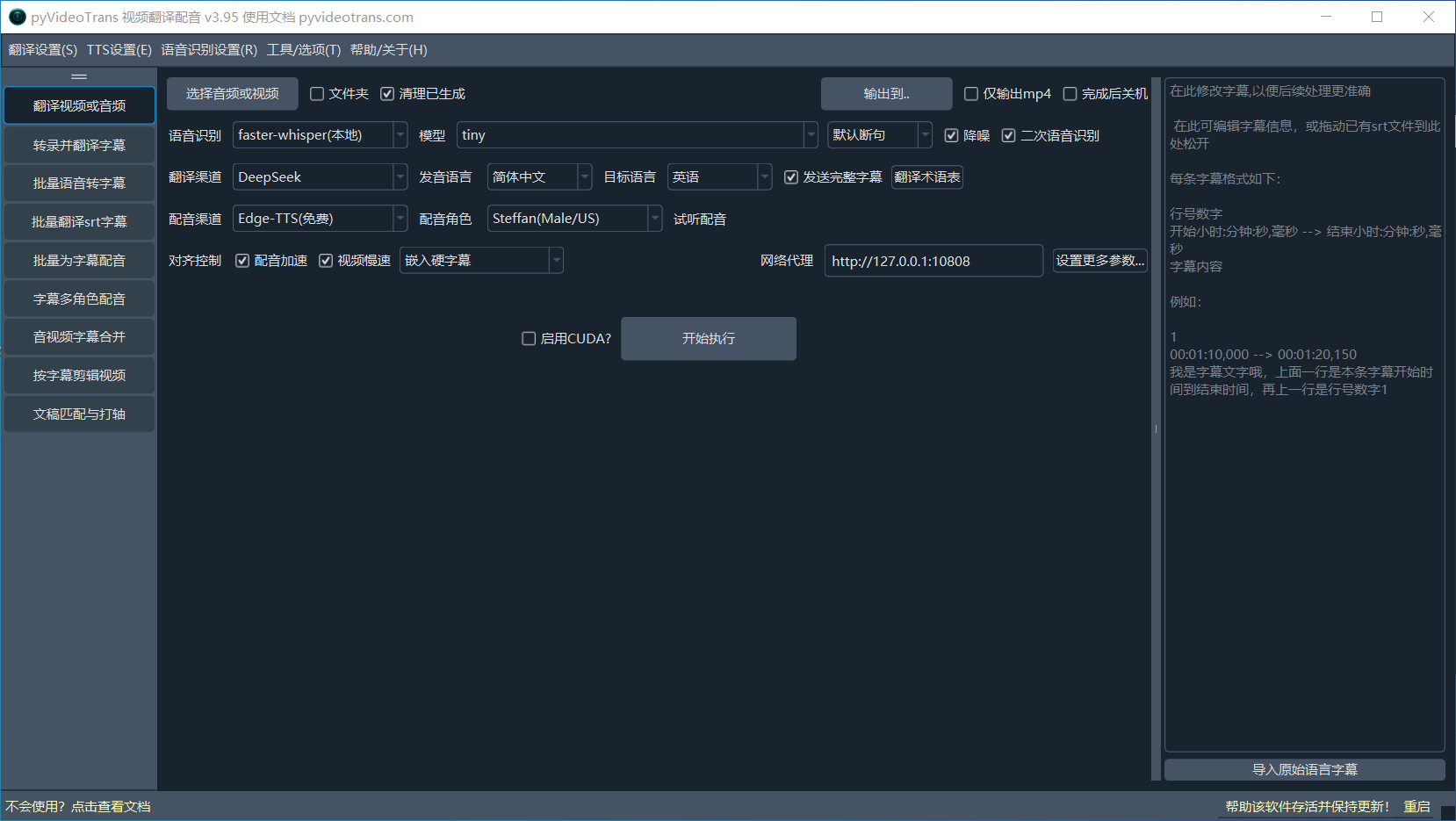

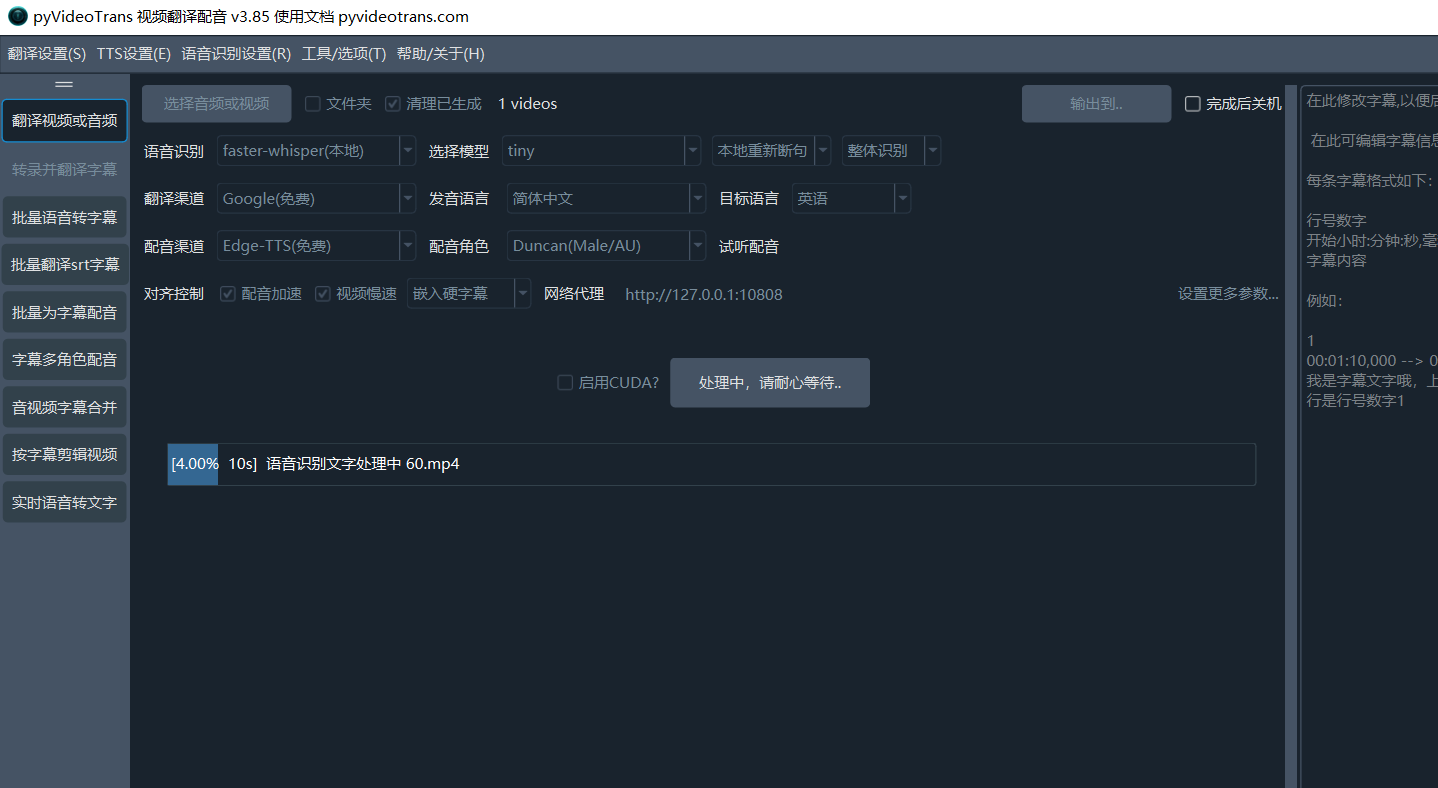

软件界面与核心功能

软件启动后,您会看到如下主界面,点击设置更多参数将显示详细配置

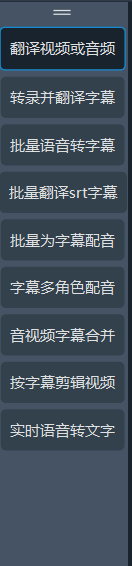

- 左侧功能区:切换软件的主要功能模块,如 翻译视频和音频 、 转录并翻译字幕 、音频视频转字幕、批量翻译srt字幕、批量为字幕配音、字幕多角色配音、音视频字幕合并、按字幕剪辑视频、文稿匹配 等。

顶部菜单栏:进行全局配置。

翻译设置:配置各个翻译渠道(如OpenAI , Azure, DeepSeek )的API Key和相关参数。

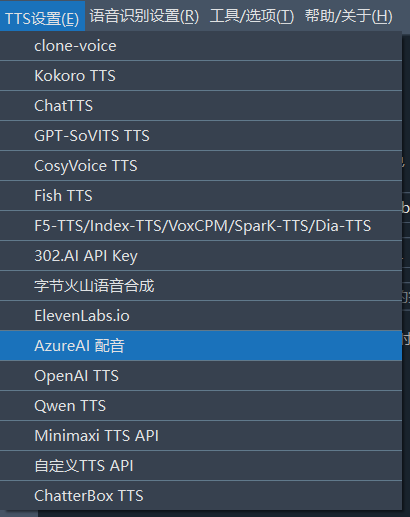

TTS设置:配置各配音渠道(如OpenAI TTS, Azure TTS)的API Key和相关参数。

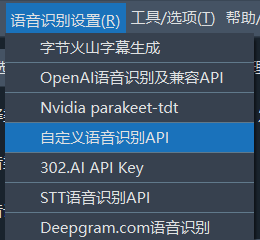

语音识别设置:配置语音识别渠道(如OpenAI API, 阿里ASR)的API Key和参数。

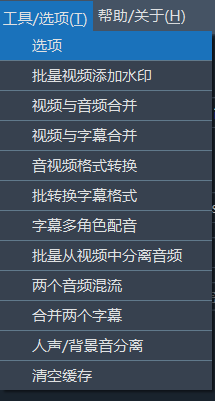

工具/选项:包含各种高级选项和辅助工具,如字幕格式调整、视频合并、人声分离等。

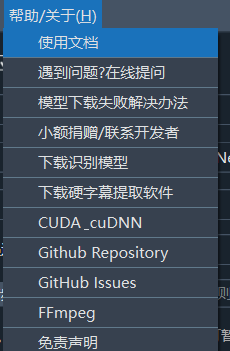

帮助/关于:查看软件版本信息、文档和社区链接。

主要功能:翻译视频和音频

打开软件默认显示的就是 翻译视频和音频 工作区,这也是软件最核心的功能。 以下将一步步带您完成一个完整的视频音频翻译任务。

第 1 行:选择要翻译的视频

支持的视频格式

mp4/mov/avi/mkv/webm/mpeg/ogg/mts/ts支持的音频格式

wav/mp3/m4a/flac/aac

选择音频或视频:点击该按钮,选择一个或多个需要翻译视频音频文件(按住Ctrl可多选)。文件夹:勾选此项可批量处理整个文件夹内的所有视频。清理已生成:若需对同一视频重新处理(而不是使用缓存),请勾选此项。输出到..:默认翻译后的文件保存到原视频目录下的_video_out文件夹,点击此按钮可单独设置翻译后视频的输出目录。完成后关机:处理完所有任务后自动关闭计算机,适合大批量、长时间任务。

第 2 行:语音识别渠道

语音识别:用来将音频或视频中的说话声转录为字幕文件,这一步的质量直接决定后续效果。支持十多种不同识别方式,faster-whisper(本地):这是本地模型(第一次运行需在线下载模型),速度和质量都较好,如无特殊需要,可选它。它有十来个不同大小的模型可选,最小最快最节省系统资源的模型是tiny,但准确度很低,不建议使用,效果最好的是 large-v3, 建议选择他们。.en结尾和distil-开头的模型只支持英语发音的视频使用。openai-whisper(本地):和上方模型基本类似,不过速度更慢一些,准确度可能略微高一点,同样建议选择 large-v3 模型。qwen-asr(本地):阿里的本地识别模型,对中文支持效果较好,如果你的原始视频是中文说话,可尝试使用它,同样第一次需在线下载模型二次识别:在选择配音并选择了嵌入单字幕时,可选中二次识别,将在配音完毕后再次对配音文件进行语音转录,生成较为简短的字幕嵌入视频内,确保字幕和配音精确对齐此外还支持 字节火山字幕生成、OpenAI语音识别、Gemini语音识别、阿里Qwen3-ASR语音识别等多种在线API及本地模型

第 3 行 翻译渠道

翻译渠道:翻译渠道用来将转录后的原始语言字幕文件,翻译为目标语言字幕文件,内置十几种翻译渠道供选择

- 免费传统翻译: Google翻译(需代理)、微软翻译(无需代理)、M2M100本地翻译、DeepLX(需自行部署)

- 收费传统翻译:百度翻译、腾讯翻译、阿里机器翻译、DeepL

- AI智能翻译:OpenAI ChatGPT、Gemini、DeepSeek、claude、智谱AI、硅基流动、302.AI 等,需自备SK密钥并填写在

菜单-翻译设置-对应渠道设置面板内。 - 兼容AI/本地模型:同时支持自行本地部署大模型,只需要选择 兼容AI/本地模型 渠道,并将api地址填写到菜单-翻译设置-本地大模型设置内即可

- 发音语言:是指原始视频中人物说话的语言,必须正确选择,如果不确定,可以选择

auto。 - 目标语言:就是你希望将音视频翻译成的目标语言。

- 翻译术语表:用于AI翻译时,发送给AI的术语

- 发送完整字幕:用于AI翻译时,附带行号和时间轴发给AI

第 4 行 配音渠道

配音渠道:翻译后的字幕文件,将使用这里指定的渠道进行配音,支持在线配音API例如OpenAI TTS/阿里Qwen-TTS/Edge-TTS/Elevenlabs/字节火山语音合成/Azure-TTS/Minimaxi等,也支持本地部署的开源TTS模型,例如 IndexTTS2/F5-TTS/CosyVoice/ChatterBox/VoxCPM等。其中Edge-TTS是免费配音渠道,开箱可用。需要配置的一些渠道,在菜单--TTS设置--对应渠道面板中填写相关信息。

- 配音角色:每个配音渠道一般都有多个发音人供选择,先选中目标语言后,即可选择配音角色。

- 试听配音:在选中某个配音角色后,即可点击试听当前角色的声音效果。

第 5 行:同步对齐和字幕

由于不同语言语速不同,翻译后的配音时长可能与原视频不符,这里可以进行调整。 主要针对配音后的时长大于原时长时进行调整,以避免声音重叠、视频已停止但声音未结束的情况,对于配音后时长变短的情况不做处理。

配音加速:如果某个配音片段比原声音片段长时,加速配音以匹配原时长。视频慢速:同样当某个配音比视频长时,放慢该片段的视频播放速度以匹配配音时长。(若选中,处理会比较耗时,同时生成大量中间片段,出于尽量减小质量损失考虑,整体尺寸会比原视频增大数倍)不嵌入字幕:只替换声音,不添加任何字幕。嵌入硬字幕:将字幕永久“烧录”到画面中,无法关闭,在任何地方播放均会显示字幕。嵌入软字幕:将字幕作为独立轨道封装进视频,播放器可选择开关,网页中播放时无法显示字幕。(双):每条字幕都由两行组成,分别是原始语言字幕和目标语音字幕。- 网络代理:对于中国大陆地区,使用 Google、Gemini、OpenAI等国外服务,需要使用代理,如果你有vpn等服务,并且知道代理端口号,可在此填写,形式类似

http://127.0.0.1:7860等。

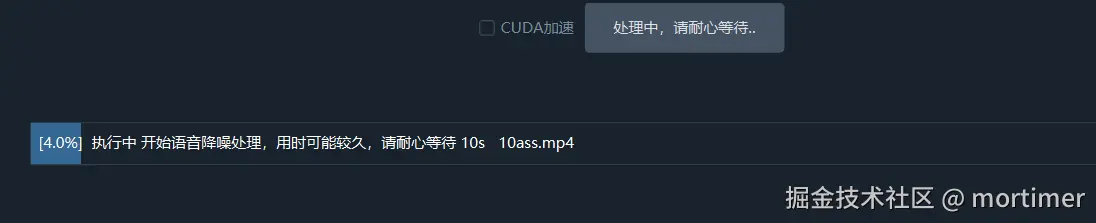

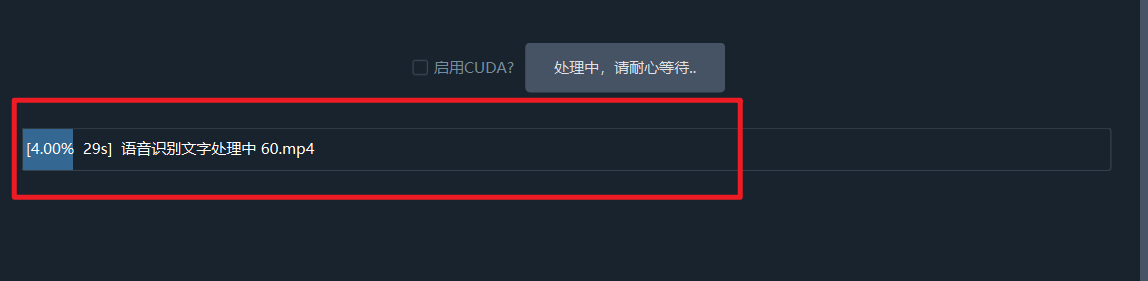

第 6 行:开始执行

- CUDA加速:在Windows和Linux上,如果您有 NVIDIA 显卡并正确安装了 CUDA 环境,请务必勾选此项,它能将语音识别的速度提升数倍甚至数十倍。

如果你有多张英伟达显卡,可打开菜单--工具--高级选项--通用设置--选中

多卡模式,将会尝试使用多卡并行处理

一切设置完毕后,点击【开始执行】按钮。

如果一次选择翻译多个音视频,将同时交叉执行,中间不会暂停。

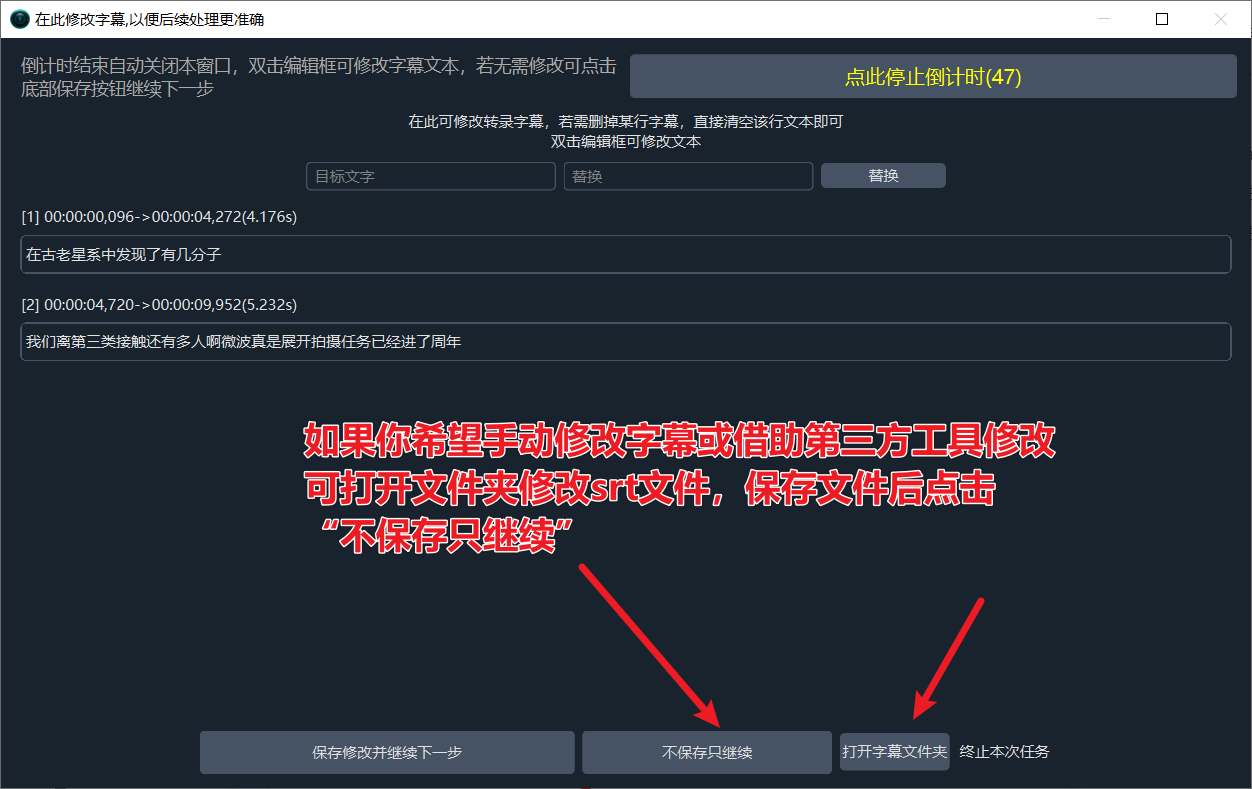

一次仅选择一个视频时,在语音转录完成后,将弹出单独的字幕编辑窗口,你可在此对字幕进行修改,以便后续过程更准确。

第 1 次修改机会:语音识别阶段完成后,弹出字幕修改窗口!在字幕翻译完成后弹出的窗口中,可为每个说话人设置不同的发音角色,还可以为每行字幕单独指定一个发音角色

第 2 次修改机会:字幕翻译阶段完成后,弹出字幕修改和发音角色修改窗口

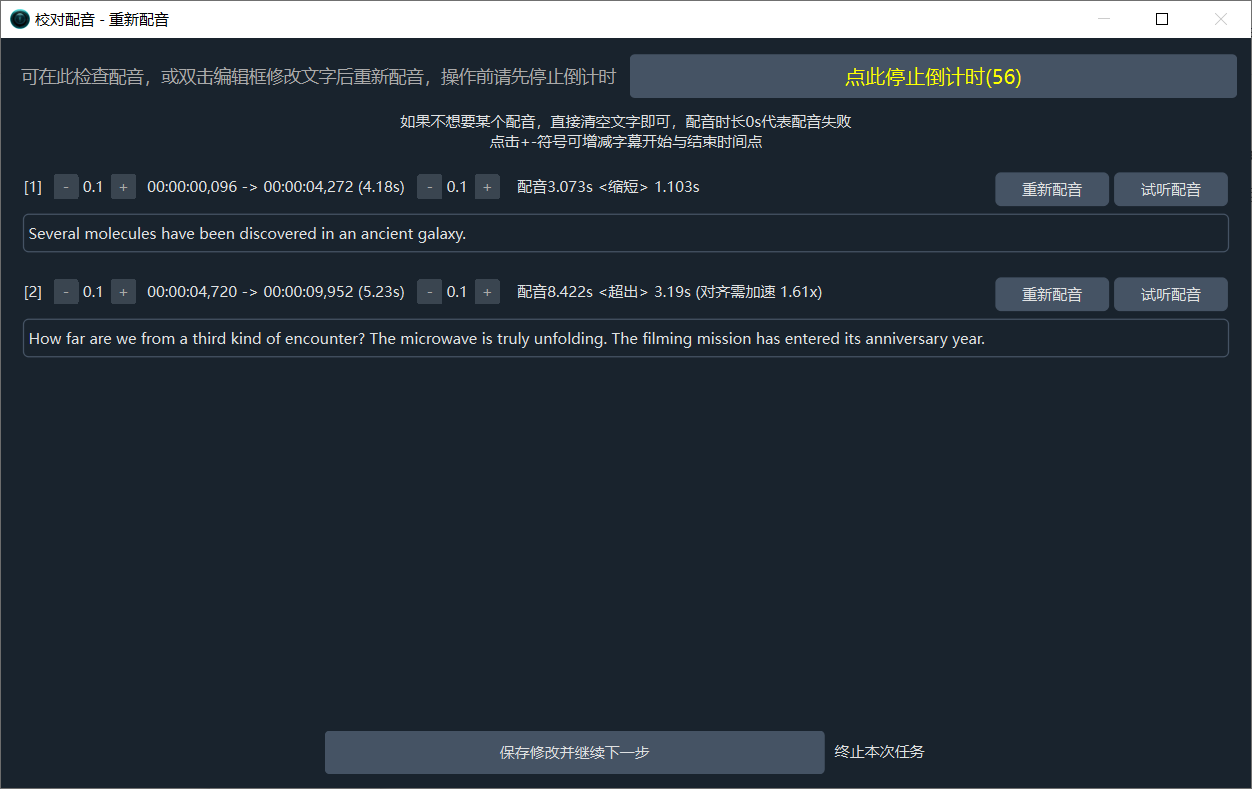

第 3 次修改机会:配音完成后,可再次检查或重新对每条字幕进行配音

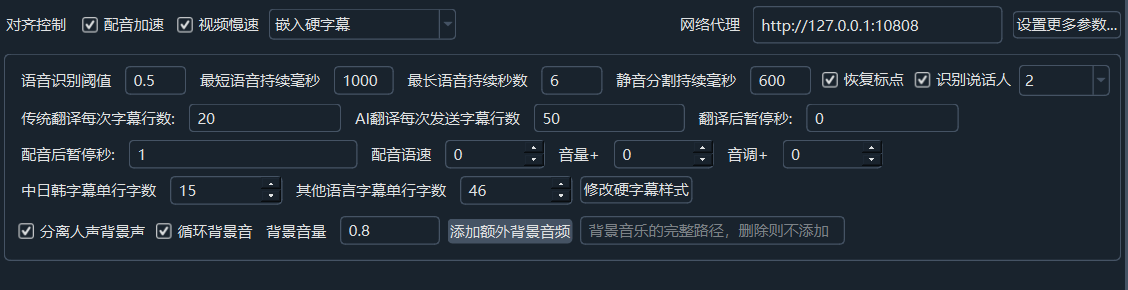

第 7 行:设置更多参数

如果你还想进行更精细的控制,例如语速、音量、每行字幕字符数、降噪、说话人识别等,可以点击 设置更多参数...,点击后如图

降噪:若选中,将在语音识别之前,在线下载modelscope.cn的阿里模型,先一步对语音中的噪声进行消除,识别准确度将得到提升

识别说话人:若选中,将在语音识别结束后,尝试识别区分说话人(准确度有限),后边的数字代表预先设定想识别出几个说话人,若提前确定,将增加准确度,默认不限制。在高级选项中可切换说话人模型(内置、阿里cam++、payanote等)

配音语速:默认0,若填写

50则代表语速加快 50%,-50代表降速 50%音量+:同样默认0,填写

50代表音量增大 50%,-50代表降低50%音调+:默认0,

20代表音调调高 20Hz变得尖锐,反正-20降低20Hz变得低沉语音阈值: 表示音频片段被认为是语音的最低概率。VAD 会为每个音频片段计算语音概率,超过此阈值的部分被视为语音,反之视为静音或噪音。默认0.5,越小越灵敏但可能误将噪声视为语音

最短语音持续毫秒数: 限制某段语音最低时长,如果你选择了克隆语音,请保持此值为>=3000

最长语音持续秒数: 限制单个语音片段的最大长度。超过此时长时强制分割。填写数字,单位是秒,默认6秒,不要大于30秒

静音分割持续毫秒数: 在语音结束时,需等待的静音时间达到此值后,才会分割出语音片段。填写数字,单位ms,默认500ms,也就是只在大于此值的静音片段处分割

传统翻译渠道每批字幕行数: 传统翻译渠道每次发送字幕行数

AI翻译渠道每批字幕行数: AI翻译渠道每次发送字幕行数

发送完整字幕: 是否在使用AI翻译渠道时发送完整字幕格式内容

翻译后暂停秒: 每次翻译后暂停秒数,用于限制请求频率

配音后暂停秒: 每次配音后暂停秒数,用于限制请求频率

中日韩单行字符:视频中嵌入字幕时,中日韩语言每行字幕最大字符数量

其他语言单行字符:视频中嵌入字幕时,非中日韩语言每行字幕最大字符数量

修改硬字幕样式:点击将弹出专门的硬字幕样式编辑器

分离人声背景声:选中将把视频中的背景伴奏声和说话声分离出来,在最终完成配音合并时,再将伴奏背景声嵌入进去(此步操作较为缓慢)

循环背景音:如果背景音频时长小于最终的视频时长,选中将循环播放背景音,否则以静音填充

背景音量:重新嵌入后新的背景音量设置,默认0.8,即音量降低为原来的 0.8 倍

额外添加背景音频:你也可以选择本地某个音频,作为新的背景伴奏

恢复标点:如果选择后,将在识别后尝试添加标点符号

第 8 行:进度条

任务完成后,点击底部进度条区域即可打开输出文件夹。您会看到最终的 MP4 文件以及过程中生成的 SRT 字幕、配音文件等素材。

从以上和软件原理可以看出,最重要的就是3个渠道,分别是 语音识别渠道 、翻译渠道、配音渠道

语音识别渠道介绍

该渠道功能是将音视频中的人类说话声音,转为SRT字幕文件,支持如下语音识别渠道

- faster-whisper本地

- openai-whisper本地

- qwen-asr本地

- 阿里FunASR中文识别

- Huggingface_ASR

- Google语音识别

- 字节火山字幕生成

- 字节语音识别大模型极速版

- OpenAI语音识别

- Elevenlabs.io语音识别

- Parakeet-tdt语音识别

- Gemini大模型识别

- 阿里百炼Qwen3-ASR

- deepgram.com语音识别

- faster-whisper-xxl.exe语音识别

- Whisper.cpp语音识别

- Whisperx-api语音识别

- 302.AI语音识别

- STT语音识别API

- 自定义语音识别API

翻译渠道介绍

翻译渠道用于将

语音识别渠道生成的原始字幕翻译为目标语言字幕,例如中文字幕翻译为英文字幕或相反

翻译结果有空白行或者缺失很多

原因分析: 在使用传统翻译渠道如 百度翻译、腾讯翻译等时,或者使用了AI翻译但没有选中 发生完整字幕 ,此时会将字幕文本按行发送给翻译引擎,期望返回同样行数的翻译结果。如果翻译引擎返回行数同发送行数不一致,此时就会出现空白行。

解决办法: 如何彻底避免这2种情况呢 避免使用本地小模型,尤其是 7b、14b、32b等小模型,如果要使用,建议 将 同时翻译的字幕数 改为 trans_thread=1 ,并取消选择发送完整字幕 打开 菜单--工具--高级设置 将 同时翻译的字幕数 改为 trans_thread=1 即可。但显然这种方式速度变慢,也无法照应上下文,效果不佳

使用更智能的在线AI大模型,例如 gemini/deepseek在线api等

- 使用AI翻译,结果中出现了提示词

在使用AI翻译渠道时,翻译结果将提示词也输出了。 这种情况多见于本地部署的小模型,例如 14b、32b等。 根本原因是模型规模太小,智能不足,无法严格遵循指令。

配音渠道介绍

用于根据字幕文件逐行进行配音,支持如下配音渠道

可在菜单--工具/选项--高级选项--配音线程数 中填写同时发起的配音任务数量,默认为1,如果你希望配音速度更快一些,可调大该值,例如设为5,即同时发起5个配音任务,但可能超出配音服务API频率限制而失败

如何进行语音克隆?

可在配音渠道中选择F5-TTS/index-tts/clone-voice/CosyVoice/GPT-SOVITS/Chatterbox等,选中clone角色,将会以原声音作为参考音频进行配音,得到原音色的配音。

打开 菜单--工具--高级设置--语音识别参数区域:建议将最短语音持续毫秒设为 3000 ,将最长语音持续秒数设为 10 ,因为 语音克隆时会自动将字幕时长对应的原始语音片段作为参考音频,而多数配音渠道均要求该参考音频时长在 3-10s 之间,否则配音很可能失败。 同时应该选中 Whisper预分割音频以及合并过短字幕到相邻,以确保字幕时长能够落在 3-10s 之间

高级选项说明

菜单-工具-高级选项中有更多精细控制,可针对此进行个性化调节。