这几年AI真是火得不行,到处都在聊它。可一说起AI,很多人要么迷糊,要么想得太玄乎,误解多得跟麻花似的。今天咱就来聊聊这些常见的误区,说得直白点,看完心里就有数了,不会被那些高大上的词唬住。

1. AI是活的,能自己想事?

真相:还是工具,没心没灵魂

一提AI,好多人脑子里就蹦出电影里的场景,觉得它跟人差不多,能自己琢磨事,甚至有点感情。其实没这回事。AI再厉害,说白了也就是个超级能算的机器。

靠数据干活: AI咋工作的?从一堆数据里找出规律,然后照着猜下一步。聊天、写文章,看着挺聪明,其实就是套路,没真心思。比如ChatGPT、Grok、deepseek这些大模型,回答问题时会一步步“推理”,看着像在思考,但那只是训练出来的步骤,不是真懂。

安慰你不是真心: 你心情不好,AI哄你两句,“别难过,日子会好的”,有人就觉得它挺贴心。其实哪有感情啊,它就是照着学来的聊天记录演戏。现在的模型还能用“思维链”(Chain of Thought)分析问题,比如劝你别干傻事,会先判断风险,再挑合适的词安慰。可这不是关心你,是程序员塞的规则,像个自动化的“暖宝宝”。

到了2025年,有些AI确实能自己检查回答,比如发现问题不安全就拒绝回答,但这不是有了意识,而是训练时加了规矩。科学家还在研究AI能不能有感情或自我意识,可眼下,它还是个没灵魂的工具。

2. AI来了,饭碗都保不住?

真相:它是帮手,没想着抢活

AI一牛起来,很多人就慌了,觉得以后啥活都归它,程序员、文科生都得歇菜。其实没必要怕成这样。

抄袭强,创新弱: AI写文章、画画、做视频确实快,因为它看了太多现成的,能模仿得像模像样。比如美国有不少艺术家联合起来告OpenAI,说它画的图跟自己的太像,就是因为数据里塞满了现成的。可要它自己想个全新点子,那就费劲了,创意还得靠人。

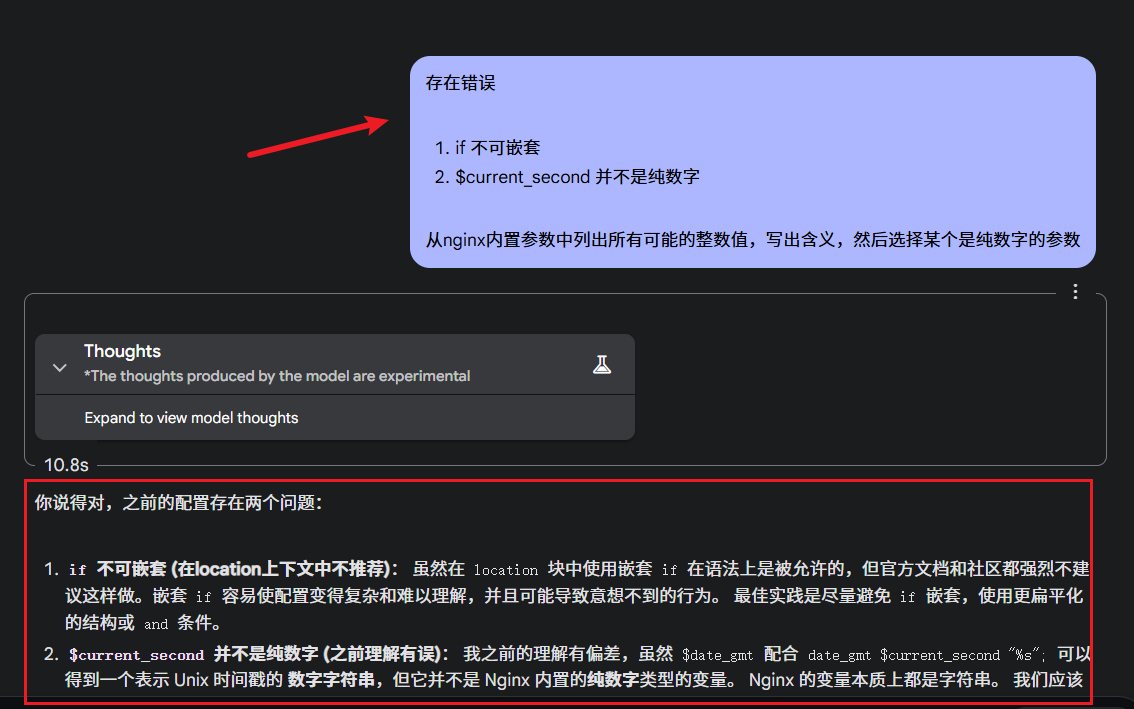

给你打下手: AI能干粗活,比如写初稿、画草图、生成代码,省点力气让你干大事儿。程序员别慌,它写代码快,但大框架咋搭、bug咋修,还得你来。现在的AI代码再好,也得改改才能用,不会写代码的人完全靠它准翻车。 如下图,这还是使用的Gemini最先进的Thinking模型

- 新活儿来了: 新技术一来,老活可能少,但新机会也多。以前黄包车没了,不新出现汽车司机、飞行员了吗?现在也一样,学着用AI搞创作、分析数据,文科生还能拿它写书、做研究,路子多着呢。

3. AI天生公平,没偏见?

真相:它也偏心,看谁喂它

有人觉得AI是机器,肯定没私心,公平得不得了。其实不然,它偏起来有时候比人还厉害。

- 数据咋喂,它咋学: AI全靠人给的数据活着。数据里女科学家少,它就觉得科学家该是男的。人脸识别也是,有的肤色准,有的迷糊,全看数据全不全。现在大模型能推理了,但推理的起点还是数据,数据歪了,它照样歪。

- 偏见改不完: 想让AI没偏见,太难了。数据总有缺口,训练再好也只能尽量少偏。比如ChatGPT会尽量给“政治正确”的回答,但这本身也是一种偏见,反映了训练数据的调调。

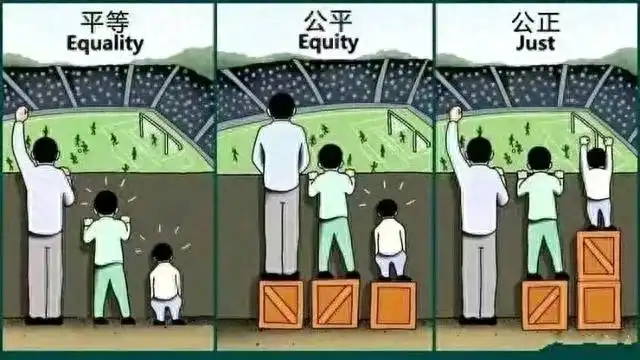

- 公平啥意思? 人自己都说不清啥叫公平,AI咋弄?现在有些模型还能自己检查偏见,比如发现回答可能歧视就改口,可这也不是真公平,是程序员定的框。

4. AI是万能的,啥都能干?

真相:工具而已,用得好坏看人

有人把AI当神仙,以为啥都能靠它搞定,也有人觉得它没道德瞎搞。其实都不全对。

- 没好坏,有规矩: AI自己不知道对错,就按人给的目标跑。比如你要它赚钱,它可能只管快,不管路子歪不歪。可现在的大模型都带“安全锁”,能自己检查问题,比如发现你问违法的事就拒绝,或者提醒你走正路。这不是AI有良心,是造它的人加的限制。

- 咋用看你: AI能帮医生诊断,也能让坏蛋捣乱。关键不在它,在人。ChatGPT、Grok这些模型回答问题前会“想一想”,但最后咋使,还是你说了算。

5. “无限制”AI啥都敢说?

真相:框早有了,偏见藏在数据里

有些AI号称“没限制无过滤”,想说啥说啥,听着挺自由。其实哪有这回事。

- 数据带着框: AI学的全是人弄的东西,像网上的文章、聊天记录,早被框住了。你问美国造的Grok对台湾啥看法,准跟美国主流调调差不多;问国产模型,答案也熟得不行。为啥?训练数据就这样。

- 偏见藏得深: 数据里“男主外女主内”多,“男女平等”少,AI自然偏那边。现在模型能自我检查,可检查的底线还是人定的,数据里的偏见跑不掉。

- 底线不一样: 国产AI管得严,怕出事;Grok这种松点,图个自由。可完全没框?不存在。到了2025年,有些AI喊着“无过滤”,但数据早把路铺死了。

AI没啥神秘的,就是个工具,用得好帮你忙,用不好添乱。别怕它,也别迷信,摸清路子用起来,才是正道!