pyVideoTrans 常见问题与解决方案

为了帮助您更好地使用 pyVideoTrans,我们整理了以下常见问题及其解决方案。

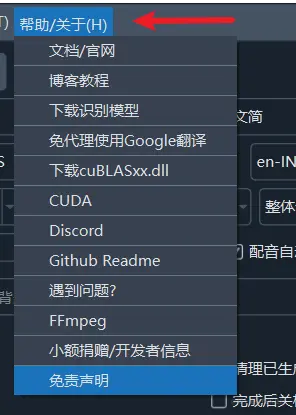

在 菜单栏--帮助/关于 中有很多链接,比如模型下载地址、CUDA配置等,遇到问题时可尝试点开使用。

第一部分:安装与启动问题

1. 双击 sp.exe 后,软件无法打开或长时间没有反应?

这通常是正常现象,请不要着急。

- 原因:本软件基于

PySide6开发,主界面包含较多组件,首次加载时需要初始化,这会消耗一些时间。根据您的电脑性能,启动时间可能在 5秒到2分钟 不等。 - 解决方案:

- 耐心等待:双击后请耐心等待一段时间。

- 检查安全软件:部分杀毒软件或安全卫士可能会阻止程序启动,请尝试暂时关闭它们,或将本软件添加到信任/白名单中。

- 检查文件路径:确保软件存放的路径只包含英文和数字,不应有中文、空格或特殊符号。例如,

D:\pyVideoTrans是一个好的路径,而D:\program file\视频 工具则可能导致问题。 - 升级包问题:如果您是覆盖了升级包后无法启动,说明操作有误。请重新下载完整的软件包,解压后再覆盖新版升级包。

2. 启动时提示缺少 python310.dll 文件怎么办?

这个问题说明您只下载了升级补丁包,而没有下载主程序。

- 解决方案:

- 请先前往官网下载 完整软件包。

- 解压完整包到指定目录。

- 之后再下载最新的升级补丁包,覆盖到完整包的目录中即可。

3. 软件需要安装吗?

本软件是绿色版,无需安装。下载完整包后解压,双击 sp.exe 即可直接运行。

4. 为什么杀毒软件会报病毒或拦截?

- 原因:本软件使用

PyInstaller工具打包,并且没有进行商业数字签名认证。一些安全软件会基于此启动风险预警,这属于常见误报。 - 解决方案:

- 添加信任:将本软件添加到您杀毒软件的信任区或白名单中。

- 源码运行:如果您是开发者,也可以选择从源代码直接部署运行,以完全避免此问题。

5. 软件支持 Windows 7 系统吗?

不支持。软件依赖的许多核心组件已不再支持 Windows 7 系统。

第二部分:核心功能与设置

6. 如何提升语音识别的准确率?

识别准确率主要取决于您选择的模型大小。

- 模型选择:在 "faster" 或 "openai" 模式下,模型越大,准确率越高,但处理速度越慢、资源消耗也越大。

tiny: 体积最小,速度最快,但准确率较低。base/small/medium: 效果与资源消耗居中,是常用的选项。large-v3: 体积最大,效果最好,对硬件要求也最高。

- 优化设置: 点击

菜单--工具--高级选项

找到 faster/openai语音识别调整 部分,进行如下修改

- 语音阈值 设为

0.5 - 最短持续时间/毫秒 设为

0 - 最大语音持续时间/秒 设为

5 - 静音分隔毫秒 设为

140 - 语音填充 设为

0

7. 为什么处理后的视频清晰度/质量降低了?

任何涉及重新编码的操作都会不可避免地导致视频质量损失。如果您希望最大程度地保持原始画质,请确保满足以下所有条件:

- 原始视频格式:使用兼容性最好的 H.264 (libx264) 编码的 MP4 文件。

- 禁用慢速处理:在功能选项中,不要勾选“视频自动慢速”。

- 不嵌入硬字幕:可以选择不嵌入字幕,或只嵌入软字幕。硬字幕会强制重新编码整个视频。

- 不改变音频或时长:不进行配音,或者在配音的同时禁止视频末尾延长功能。

- 高级选项-视频输出质量控制:数字默认23,可以降低到18或更低(最低0),越低输出视频质量越高,但尺寸也越大

- 高级选项-输出视频压缩率:默认是

fast,可用选择slow或slower,质量会更高,但输出耗时将增加 - 高级选项-264/265编码:默认是

264,可选265,输出视频质量更高

8. 为什么输出视频超级大?

- 修改高级选项-视频输出质量控制 为 25-51 越大输出视频尺寸越小,但质量也随之降低

- 高级选项-264/265编码:选择265,同质量下 265 尺寸更小

9. 如何配置网络代理?

部分翻译或配音服务(如 Google、OpenAI、Gemini)在国内无法直接访问,需要通过网络代理。

- 设置方法:在主界面的“网络代理地址”文本框中,填入您的代理服务地址。

- 格式要求:通常是

http://127.0.0.1:10808或socks5://127.0.0.1:10808这样的格式(端口号需根据您的代理客户端设置填写)。 - 重要提示:如果您不了解代理或没有可用的代理服务,请将此项留空。错误的设置将导致所有网络功能(包括国内服务)无法使用。

10. 如何自定义字幕的字体、颜色和样式?

- 点击主界面中的修改硬字幕

- 在此处您可以修改硬字幕的字体、大小、颜色、边框样式等。

- 颜色代码说明:颜色代码格式为

&HBBGGRR&,与常见的 RGB 相反,顺序是 蓝绿红 (BGR)。- 白色:

&HFFFFFF& - 黑色:

&H000000& - 纯红色:

&H0000FF& - 纯绿色:

&H00FF00& - 纯蓝色:

&HFF0000&

- 白色:

第三部分:常见问题与故障排查

10. 批量翻译视频,比如30-50-100个视频时,总是会卡住?

默认批量任务时,会将每个任务分为多个阶段,同时交叉并行处理,太多任务时可能导致资源耗尽,可以选中高级选项--批量翻译时强制串行,将执行方式改为串行,即只有第一个视频完全翻译结束后,才开始执行第二个,依次顺序执行

11. 为什么处理后出现声音、字幕、画面不同步?

这是语言翻译中的正常现象。

- 原因:不同语言表达同一个意思时,句子的长度和发音时长都会发生变化。例如,一句2秒的中文,翻译成英文后,配音时长可能变为4秒。这种时长变化会导致配音与原始画面的口型和时间轴无法完全对齐。

12. 总是提示显存不足 (例如 Unable to allocate 错误)?

这个错误意味着您的显卡没有足够的内存(VRAM)来执行当前任务,通常是因为使用了大型模型或处理长视频。

- 解决方案(按推荐顺序尝试):

- 使用更小的模型:将识别模型从

large-v3更换为medium、small或base。large-v3模型最低需要 8GB 显存,但实际运行时,其他程序也会占用显存。 - 调整高级设置:在菜单栏

工具/选项->高级选项中进行如下修改,以牺牲一些精度换取更低的显存占用:CUDA数据类型: 将float32改为float16或int8。beam_size: 将5改为1。best_of: 将5改为1。上下文: 将true改为false。

- 将整体识别下拉框选中为

批量推理,此时会预先将语音切片为小片段,然后多个片段同时执行

- 使用更小的模型:将识别模型从

13. 已经安装了 CUDA,为什么软件还是无法使用 GPU 加速?

请检查以下可能的原因:

- CUDA 版本不兼容:本软件内置的 CUDA 支持版本为 12.8。如果您的 CUDA 版本过低,将无法调用。

- 显卡驱动过旧:请更新您的 NVIDIA 显卡驱动到最新版本。

- 缺少 cuDNN:确保您已经正确安装了与 CUDA 版本匹配的 cuDNN。

- 硬件不兼容:GPU 加速仅支持 NVIDIA 显卡(N卡)。AMD 或 Intel 的显卡无法使用 CUDA。

14. 执行过程中报错,错误信息包含 “ffprobe exec error” 或 ffmpeg?

这个错误通常与文件路径过长或含有特殊符号有关。

- 原因:Windows 系统对文件路径有最大长度限制(通常是260个字符)。如果您的视频文件名本身很长(例如从 YouTube 下载的视频),并且存放的文件夹层级很深,总路径就容易超出限制。

- 解决方案:将视频文件移动到更浅的目录(如

D:\videos),并将其重命名为一个简短的英文或数字名称。

15. 软件提示视频“不含音轨”?

- 可能原因 1:视频确实没有声音。例如,从Youtube和其他某些网站下载的视频,画面和声音是分开的,可能在合并时出错导致音频丢失。

- 可能原因 2:背景噪音过大。如果视频环境非常嘈杂(如街道、演唱会),人声被掩盖,模型可能无法识别到有效的语音。

- 可能原因 3:语言选择错误。请确保您在“原始语音”选项中选择的语言与视频中人物实际所说的语言一致。例如,视频里是英文对话,您必须选择“英语”才能正确识别。

16. GPU 使用率很低,正常吗?

正常。软件的工作流程是:语音识别 -> 文字翻译 -> 文本配音 -> 视频合成。

只有在第一步 “语音识别” 阶段,才会大量使用 GPU 进行运算。其他阶段(如翻译、合成)主要依赖 CPU,因此 GPU 在大部分时间处于低负载状态是符合预期的。

17. 反复处理同一个视频,为什么识别结果和字幕总是不变?

- 原因:为了节省时间和计算资源,软件默认启用了缓存机制。如果检测到某个视频已经生成过字幕文件,它会直接使用缓存结果,而不会重新处理。

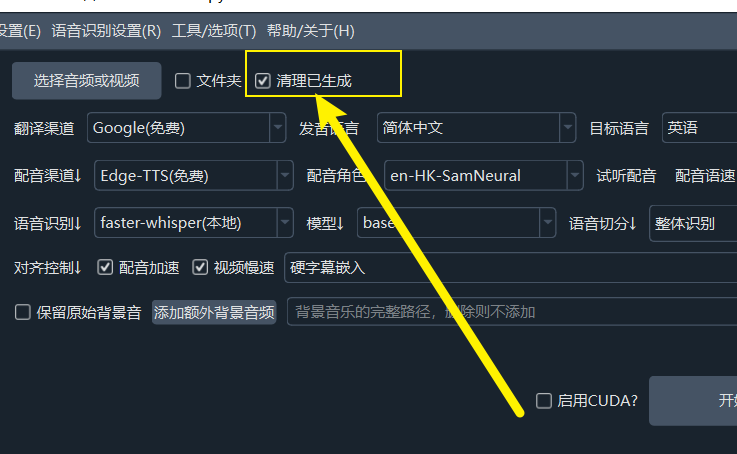

- 解决方案:如果您希望强制重新识别和翻译,请在软件主界面的左上角,勾选

清理已生成复选框。

18. 处理几个视频后,发现硬盘空间被占满?

这通常是由于启用了“视频慢速”功能并产生了大量临时文件。

- 原因:该功能会将视频按字幕切割成许多小片段,并对每个片段进行处理,这会产生远超原视频体积的缓存文件。

- 解决方案:

- 手动清理:处理完成后,可以手动删除软件根目录下的

tmp文件夹内的所有内容。 - 自动清理:正常关闭软件时,程序会自动清理这些缓存。

- 手动清理:处理完成后,可以手动删除软件根目录下的

第四部分:综合信息

18. 软件是否支持 Docker 部署?

目前不支持。

19. 能否识别视频画面中的硬字幕(OCR 功能)?

不能。本软件的原理是分析视频中的音频轨道,识别出人类的语音并转换为文字。它不具备图像文字识别(OCR)功能。

20. 我可以添加新的语言支持吗?

不能。增加一种语言意味着需要对应的语音识别渠道、字幕翻译渠道、配音渠道进行支持,每种渠道都对应着多种不同的本地模型或在线API接口,他们是否支持新增的语言、以及即便支持不同方式也要求同一种语言的不同格式代码,例如中文有的渠道要求zh,而有的要求zh-cn或chi等,如果任意增加,会导致各种意料之外的错误,除非你会编码,可以自行修改源码,否则不可增加。

21. 软件是否收费?可以商用吗?

- 费用:本项目是一个免费且开源的软件,您可以免费使用所有功能。请注意,如果您使用第三方的翻译或TTS(文本转语音)或语音转录接口,这些服务商可能会收取费用,但这与本软件无关。

- 商用:个人和公司均可自由使用本软件。但如果您希望将本项目的代码集成到您自己的商业产品中,则必须遵守 GPL-v3 开源协议。此外某些渠道使用的模型或在线API可能有他们自己的协议要求,是否允许商用,请咨询所使用的渠道对应的平台,例如Edge-tts渠道硬咨询微软、ChatTTS配音渠道应咨询

https://github.com/2noise/ChatTTS

22. 是否提供人工客服?

没有。本项目为个人开发的免费开源软件,没有盈利,因此无法配备专门的人工客服团队。如果您遇到问题,请先仔细阅读本 FAQ。 或你也可以选择软件右下角微信二维码打赏,留言你的微信号,获取有偿技术支持。